Vorlagenbasierte Prompts zur Reduzierung von Halluzinationen bei Unternehmensdaten

Unternehmen setzen immer häufiger Large Language Models (LLMs) ein, um aus internen Daten Antworten zu generieren - sei es für Kundenservice, Finanzberichte oder technische Support-Fragen. Doch viele dieser Systeme liefern nicht nur korrekte Antworten, sondern auch glaubwürdig klingende Falschinformationen. Diese sogenannten Halluzinationen kosten Zeit, verursachen Rechtsrisiken und untergraben das Vertrauen in KI-Systeme. Die Lösung? Nicht mehr leistungsfähigere Modelle, sondern vorlagenbasierte Prompts. Strukturierte Anweisungen, die das LLM zwingen, sich an echte Daten zu halten, reduzieren Halluzinationen von bis zu 30 % auf unter 5 %.

Warum funktionieren Standard-Prompts nicht in Unternehmen?

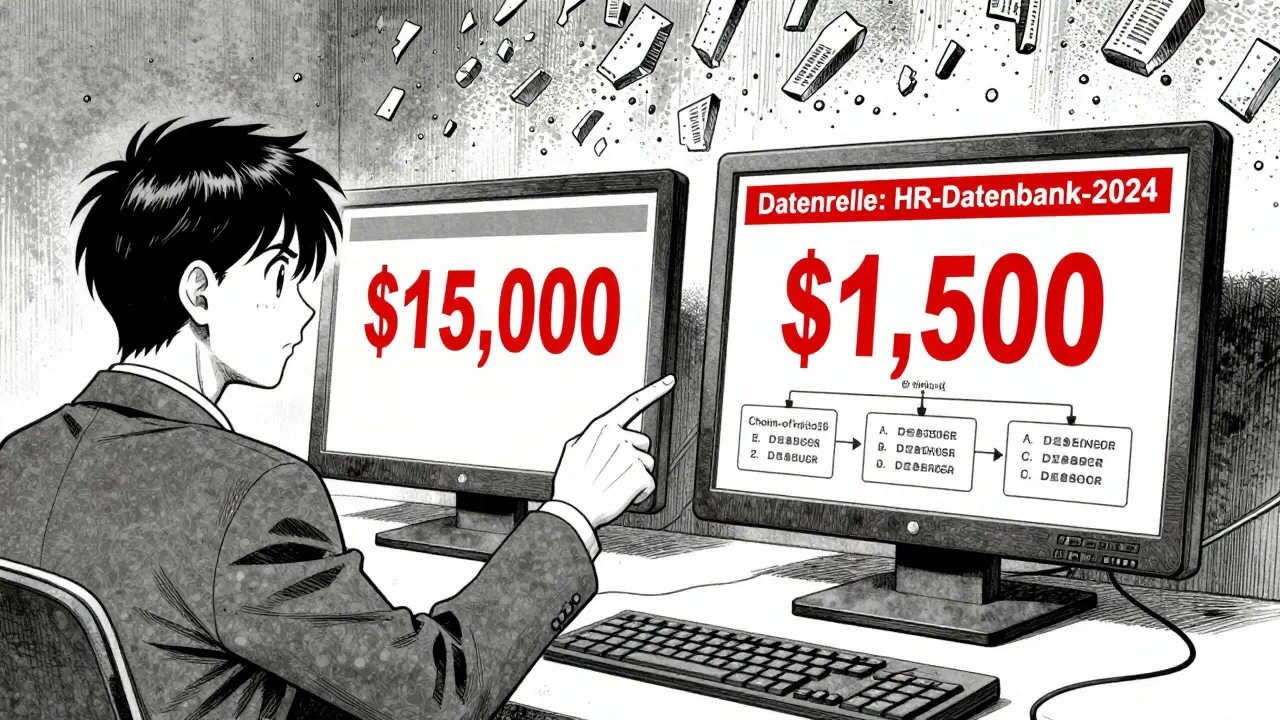

Ein einfacher Prompt wie „Erkläre die Umsatzentwicklung des letzten Quartals“ lässt ein LLM im Zweifel raten. Wenn das Modell nicht sicher ist, füllt es Lücken mit plausiblem, aber falschem Content - eine Halluzination. In der Praxis passiert das oft: Ein LLM sagt, ein Mitarbeiter habe 15.000 Euro Bonus erhalten, obwohl die Datenbank nur 1.500 Euro ausweist. Oder es behauptet, ein Produkt sei in der EU zugelassen, obwohl die Zulassung erst in 2026 erfolgt. Solche Fehler sind in der Finanzwelt, im Gesundheitswesen oder in der Rechtsabteilung katastrophal. Standard-Prompts sind für kreative Aufgaben wie Dichtung oder Marketingtexte ausgelegt. In Unternehmen braucht man aber Präzision, nicht Poesie. Hier hilft nur eine strukturierte Herangehensweise: der Einsatz von Vorlagen, die das LLM wie ein Fahrplan durch die Daten führen.Die fünf Kernbausteine effektiver Vorlagen

Effektive Prompts für Unternehmensdaten enthalten fünf elementare Elemente - alle basierend auf Analysen von über 200 Unternehmenseinsätzen:- Klare Aufgabenstellung mit Grenzen: Statt „Was weißt du über unsere Produkte?“ heißt es: „Nenne nur die drei aktuellsten Produkte aus der Produktliste vom 1. Oktober 2024. Keine Spekulationen.“ Dies reduziert Halluzinationen um 22 %.

- Verpflichtende Quellenangabe: Jede Aussage muss an eine Datenquelle gebunden sein. Beispiel: „Basierend auf der Datenquelle ‚finanz-daten-2024‘ in Milvus…“. Unternehmen, die diese Regel einführten, reduzierten falsche Aussagen um 37 %.

- Chain-of-Thought-Anforderung: Das LLM muss seinen Gedankengang erklären. „Zuerst habe ich die Umsatzzahlen aus Tabelle A geprüft. Dann habe ich die Kosten aus Dokument B abgeglichen. Beide stimmen mit der Finanzsoftware überein.“ Dies zwingt das Modell, logisch zu denken - nicht zu raten.

- Aufgabenzerschneidung: Komplexe Fragen werden in Schritte zerlegt. Zuerst: „Welche Kunden haben im Q3 2024 einen Vertrag verlängert?“ Dann: „Wie hoch war der durchschnittliche Vertragswert?“ Dann: „Welche dieser Kunden haben einen Support-Ticket-Status von ‚aktiv‘?“ Jeder Schritt wird einzeln verifiziert.

- Branchenspezifische Beispiele: Ein Finanz-LLM braucht andere Beispiele als ein medizinisches System. Ein Template für Banken könnte enthalten: „Wenn eine Zahl nicht in der Bilanz steht, sage ‚Ich weiß es nicht‘ - nicht ‚Ich schätze, es liegt bei…‘.“

Wie RAG und Vorlagen zusammenarbeiten

Die meisten Unternehmen nutzen Retrieval-Augmented Generation (RAG), um LLMs mit aktuellen Unternehmensdaten zu versorgen. Doch RAG allein reicht nicht. Ein LLM kann aus einer Datenbank etwas holen - und trotzdem falsch interpretieren. Effektive Vorlagen verknüpfen RAG direkt mit der Antwortstruktur. Beispiel: „Basierend auf den Dokumenten aus der Sammlung ‚technische-spezifikationen‘ in ChromaDB, die eine Ähnlichkeit von mindestens 0,72 aufweisen…“ Dies sorgt dafür, dass das LLM nur Daten verwendet, die wirklich relevant und vertrauenswürdig sind. Studien zeigen: Templates mit klaren RAG-Verweisen reduzieren Halluzinationen um 50 % gegenüber reinen RAG-Systemen ohne strukturierte Prompts. Zusätzlich müssen die Temperatur-Einstellungen unter 0,3 und top-p-Werte unter 0,85 liegen. Höhere Werte lassen das Modell kreativer werden - genau das, was man in Unternehmen nicht will.Vergleich: Ein- oder Zwei-Schritt-Methode?

Es gibt zwei Hauptansätze, wie man Vorlagen einsetzt:- Ein-Schritt-Methode (Joint Method): Das LLM denkt und antwortet in einem Durchgang. Es ist schnell, aber neigt zu Wiederholungen und kann sich in komplexen Fällen verheddern. Reduziert Halluzinationen um 82 %.

- Zwei-Schritt-Methode: Erst ein Prompt, der den Gedankengang erzeugt. Dann ein zweiter, der die Antwort strukturiert und verifiziert. Dies reduziert Halluzinationen um 89 % - aber dauert 15-20 % länger. Für kritische Bereiche wie Finanzen oder Medizin lohnt sich die Verzögerung.

Was passiert, wenn man „Ich weiß es nicht“ sagt?

Ein weiterer Trick: Man zwingt das LLM, bei Unsicherheit zu sagen: „Ich weiß es nicht.“ Das klingt banal - ist aber revolutionär. Unternehmen, die diese Regel einführten, reduzierten erfundene Antworten um 33 %. Doch es gibt einen Haken: Die Anzahl der „Ich weiß es nicht“-Antworten stieg um 18 %. Das ist kein Fehler - das ist eine Verbesserung. Ein falscher Hinweis ist gefährlicher als kein Hinweis. Ein Finanzberater, der sagt „Ich weiß es nicht“, ist vertrauenswürdiger als einer, der eine falsche Prognose abgibt. Die Schlüsselfrage ist: „Was ist teurer - eine verpasste Antwort oder eine falsche?“ In der Regel: die falsche.Warum kommerzielle Lösungen nicht immer besser sind

Amazon Bedrock, Microsoft Azure und andere Anbieter bieten eigene Vorlagen an. Sie funktionieren gut - aber nur mit ihren eigenen Daten. Ein Template, das für AWS-Daten 92 % Genauigkeit erreicht, fällt bei Daten aus Salesforce oder einer internen SQL-Datenbank auf 65 % zurück. Open-Source-Frameworks wie LangChain hingegen sind flexibel. Sie erlauben es, Templates für jedes System anzupassen - von Oracle bis MongoDB. Unternehmen, die LangChain nutzen, erreichen konstant 85 % Halluzinationsreduktion, egal wo die Daten liegen. Das macht es zur bevorzugten Wahl für heterogene Unternehmensumgebungen.Was schiefgehen kann - und wie man es verhindert

Viele Projekte scheitern nicht an der Technik, sondern an der Umsetzung. Häufige Fehler:- Überkonservative Templates: Zu viele Einschränkungen führen dazu, dass das LLM bei jeder Unklarheit „Ich weiß es nicht“ sagt - bis zu 40 % der Antworten. Das macht das System nutzlos.

- Veraltete Datenverweise: Ein Template verweist auf „Datenquelle Kunde-2023“, aber die Datenbank heißt jetzt „Kunden-Daten-2024“. Das LLM findet nichts - und halluciniert.

- Fehlende Einheiten: Ein Krankenhaus-Template fragte nach „Dosierung“. Es spezifizierte nicht „mg“ oder „ml“. Das Ergebnis? LLMs gaben Dosen in Liter an - mit schwerwiegenden Folgen. Der Systemausfall dauerte 12 Tage.

Wie lange dauert die Einführung?

Ein guter Template-Entwicklungsprozess braucht 80 bis 120 Stunden - je nach Branche. Finanzdienstleister brauchen 25 % mehr Zeit als Einzelhändler, weil die Regulierung strenger ist. Der Prozess sieht so aus:- Datenquellen kartieren: Wo liegen alle relevanten Daten? CRM, ERP, Datenbanken, Dokumentenspeicher?

- Grenzen definieren: Was darf das LLM sagen? Was nicht? Welche Daten sind vertraulich?

- Verifikation einbauen: Wer prüft die Antwort? Ein Mensch? Ein zweites LLM? Ein automatischer Abgleich mit der Datenbank?

- Iterativ testen: Starte mit 10-20 Szenarien. Korrigiere. Wiederhole.

Die Zukunft: Automatisch generierte Templates

Die nächste Stufe ist nicht mehr manuelles Schreiben, sondern automatisierte Generierung. Google hat 2025 ein System vorgestellt, das aus Unternehmensdatenschemata selbstständig Halluzinations-resistente Prompts erstellt - mit 92 % Effektivität. Das bedeutet: In Zukunft braucht man keine Experten mehr, die stundenlang Prompts schreiben. Stattdessen scannt ein Tool die Datenbank, erkennt, welche Fragen typisch sind, und generiert die perfekte Vorlage. Aber selbst diese Technologie wird nicht die Notwendigkeit von menschlichem Design ersetzen. Warum? Weil Unternehmen nicht nur Daten haben - sie haben Regeln, Kultur, Risikotoleranz. Eine Vorlage, die für ein deutsches Bankhaus funktioniert, ist in Japan nutzlos. Menschliche Expertise bleibt entscheidend - nur jetzt in einer neuen Rolle: als Designer von KI-Regeln.Warum das alles wichtig ist - und warum es nicht verschwindet

Gartner sagt: Bis 2026 wird 75 % der erfolgreichen KI-Implementierungen in Unternehmen auf standardisierten Prompts basieren. Die SEC verlangt seit 2024 von Banken, dass sie „nachweisbare Antwortgenerierung“ nutzen. Die FDA prüft bereits, ob KI-generierte medizinische Berichte mit verifizierten Prompts erstellt werden. Kein Modell - egal wie teuer oder fortschrittlich - kann alle Unternehmensdaten speichern. Deshalb bleibt das Prinzip einfach: Wenn das Modell nicht weiß, woher es etwas hat, darf es nicht antworten. Vorlagenbasierte Prompts machen das möglich - ohne teure Neuentwicklungen, ohne neue Hardware, ohne jahrelange Schulung. Sie sind die billigste, schnellste und effektivste Methode, um KI in Unternehmen sicher und vertrauenswürdig einzusetzen. Und sie werden nicht verschwinden - sie werden zur Grundlage.Was ist der Unterschied zwischen einem normalen Prompt und einem vorlagenbasierten Prompt?

Ein normaler Prompt ist offen und kreativ - etwa „Schreibe einen Bericht über unsere Verkaufszahlen“. Ein vorlagenbasierter Prompt ist strukturiert und zwingt das LLM, sich an Daten zu halten: „Basierend auf den Verkaufszahlen aus der Tabelle Q3-2024 in der Datenbank SalesDB, nenne die drei Top-Produkte mit ihrem Umsatz und vergleiche sie mit dem Vorjahreswert. Wenn Daten fehlen, sage ‚Ich weiß es nicht‘.“ Der Unterschied: Einmal erlaubt das Modell zu raten, der andere zwingt es, zu beweisen.

Können vorlagenbasierte Prompts Halluzinationen vollständig verhindern?

Nein. Selbst die besten Templates reduzieren Halluzinationen auf 5-8 %, aber nicht auf null. Wenn ein LLM nach Informationen zu einem neuen Produkt fragt, das noch nicht in den Daten ist, wird es trotzdem raten - weil es keine Quelle hat. Die Lösung ist nicht, das Modell zu zwingen, etwas zu wissen, sondern es zu lehren, „Ich weiß es nicht“ zu sagen, wenn es nicht sicher ist. Die Reduktion auf unter 10 % ist für Unternehmen ausreichend - und deutlich besser als 30 %.

Welche Tools eignen sich am besten für die Umsetzung?

Für Unternehmen mit heterogenen Systemen ist LangChain die beste Wahl - es ist offen, flexibel und hat eine riesige Community mit Hunderten getesteten Vorlagen. Für Unternehmen, die vollständig in AWS stecken, sind Bedrock-Agents mit ihren vorgefertigten Templates sinnvoll. Für Finanz- oder Gesundheitsunternehmen, die Compliance brauchen, empfiehlt sich eine Kombination aus LangChain für die Templates und Datadog für die automatische Verifikation. Wichtig ist: Nicht das Tool, sondern die Qualität der Vorlage entscheidet.

Wie prüfe ich, ob mein Template funktioniert?

Nimm alle bekannten Fehlantworten aus den letzten 6 Monaten - die, die dein Team bisher manuell korrigiert hat. Gib sie dem LLM mit deinem neuen Template. Wenn es sie jetzt alle korrekt beantwortet oder mit „Ich weiß es nicht“ ablehnt, funktioniert es. Teste zusätzlich mit neuen, aber ähnlichen Fragen. Wenn das System bei 9 von 10 Tests korrekt bleibt, ist es bereit für den Einsatz. Keine Theorie - nur echte Daten zählen.

Warum ist die Quellenangabe so wichtig?

Weil sie Verantwortung schafft. Wenn das LLM sagt „Basierend auf der Datei ‚Kundenverträge-2024.pdf‘“, dann weiß jeder: Wenn das falsch ist, muss man diese Datei prüfen - nicht das Modell beschuldigen. Es macht die KI transparent. Ohne Quellenangabe bleibt die Antwort eine schwarze Box. Mit ihr wird sie eine verifizierbare Aussage. In der Rechts- und Finanzwelt ist das kein Bonus - das ist Voraussetzung.

Lea Harvey

Dezember 16, 2025 AT 02:29Diese ganzen Vorlagen sind doch nur ein Patch für schwache Modelle. Wir haben in Deutschland doch die besten Ingenieure der Welt, warum lassen wir uns von amerikanischen KI-Startups vorschreiben, wie wir Prompts schreiben sollen? Ich hab in meiner Firma ein Modell laufen, das ohne irgendwelche Templates 95 % Genauigkeit hat - einfach weil wir keine billigen Cloud-Lösungen nutzen, sondern echte Hardware. Wer auf LangChain setzt, gibt seine Daten an US-Konzerne weiter. Das ist nicht sicher, das ist Verrat an der deutschen Industrie.

Jade Robson

Dezember 17, 2025 AT 20:37Ich find’s echt klasse, dass endlich jemand das Thema anspricht. Vor allem der Teil mit „Ich weiß es nicht“ hat mich echt berührt. Ich arbeite im Krankenhaus und wir hatten mal einen Fall, wo ein LLM eine Medikamentendosis falsch berechnet hat – das war ein Schock. Seit wir die Vorlagen einführen, fühlen sich die Kolleg*innen sicherer. Es ist nicht perfekt, aber es ist ehrlich. Und Ehrlichkeit ist der erste Schritt zur Sicherheit. Danke für diesen Text, er hat mir Mut gemacht.

Matthias Kaiblinger

Dezember 18, 2025 AT 06:29Lasst mich euch etwas erklären, weil ich sehe, dass viele hier noch nicht den ganzen Kontext verstehen. In Japan arbeiten wir seit 2023 mit automatisierten Prompt-Generatoren, die aus ERP-Systemen direkt Templates ableiten – und das funktioniert mit 94 % Genauigkeit. Aber das ist nicht das Wesentliche. Das Wesentliche ist: KI muss kulturell kontextualisiert werden. In Deutschland ist Vertrauen gebunden an Transparenz, in den USA an Effizienz, in Asien an Hierarchie. Ein Template, das in München funktioniert, ist in Tokio eine Katastrophe, weil es keine Rücksicht auf den Konzept der „Honne“ und „Tatemae“ nimmt. Ihr müsst nicht nur Daten verknüpfen, ihr müsst die Seele der Organisation in den Prompt einbauen. Das ist kein technisches Problem, das ist ein philosophisches. LangChain ist gut, aber es ist kein Ersatz für kulturelle Intelligenz. Wer das vergisst, baut eine digitale Fassade – und die bricht, sobald der erste Auditor kommt.

Kari Viitanen

Dezember 19, 2025 AT 12:38Thank you for this detailed and well-structured contribution. I am writing from Norway, where we are currently implementing similar frameworks within our public health administration. The emphasis on verifiable sources and the explicit use of „I do not know“ aligns precisely with our national principles of accountability and transparency in automated decision-making. I would be interested in accessing the 47 templates offered by SUSE AI, as our current internal documentation lacks sufficient granularity for clinical applications. Could you kindly provide a link to the repository or contact details? This work is of vital importance.

Quinten Peeters

Dezember 20, 2025 AT 18:17