Verlust und Perplexity überwachen: Signale während des LLM-Trainings lesen

Wenn du ein Large Language Model (LLM) trainierst, siehst du täglich Zahlen - viele Zahlen. Aber welche davon sagen dir wirklich, ob das Modell besser wird? Die Antwort liegt in zwei einfachen, aber mächtigen Metriken: Verlust und Perplexity. Sie sind nicht die letzten Worte über die Qualität eines Modells, aber sie sind die ersten, die du sehen musst. Und wenn du sie falsch interpretierst, läufst du Gefahr, wochenlang auf einem falschen Pfad zu trainieren.

Was ist Perplexity - und warum ist sie so wichtig?

Perplexity misst, wie überrascht ein Modell ist, wenn es einen Text liest. Stell dir vor, du gibst dem Modell einen Satz wie „Der Hund läuft im Garten“ und fragst: „Welches Wort kommt als nächstes?“ Wenn das Modell mit 90% Sicherheit „Garten“ vorhersagt, ist die Perplexity niedrig. Wenn es zwischen „Garten“, „Haus“, „Auto“ und „Banane“ schwankt, ist sie hoch. Je niedriger die Zahl, desto besser versteht das Modell Sprache.

Mathematisch ist Perplexity einfach die Exponentialfunktion der Kreuzentropie-Verlustfunktion: PPL = exp(-durchschnittlicher negativer Log-Likelihood pro Token). Das klingt kompliziert, ist es aber nicht. Ein Modell mit einer Perplexity von 20 bedeutet: Bei jedem Wort, das es vorhersagt, ist es so unsicher, als müsste es zwischen 20 gleich wahrscheinlichen Optionen wählen. Ein Modell mit Perplexity 10 ist doppelt so sicher - es denkt, es hat nur 10 mögliche Wörter zur Auswahl.

State-of-the-Art-Modelle erreichen heute Werte zwischen 10 und 25 auf Benchmarks wie Penn Treebank. GPT-3 hatte 20,5, GPT-2 noch 25,6. Diese Zahlen sind nicht willkürlich - sie zeigen, wie viel Sprachmuster das Modell gelernt hat.

Verlust vs. Perplexity: Was ist der Unterschied?

Der Verlust (Cross-Entropy Loss) ist die Grundlage. Er wird in Nats oder Bits gemessen und sagt dir: „Wie schlecht war die Vorhersage?“ Ein Wert von 2,5 bedeutet, dass das Modell im Durchschnitt 2,5 Bits an Information verliert, wenn es ein Wort vorhersagt. Aber 2,5 ist für Menschen schwer zu greifen. Was bedeutet das? Ist das gut? Schlecht?

Perplexity macht das greifbar. Sie transformiert den Verlust in eine Zahl, die du dir vorstellen kannst. 2,5 Nats entsprechen einer Perplexity von etwa 12. Das ist ein klarer Signalton: „Das Modell ist relativ sicher.“

Und hier ist der entscheidende Punkt: Perplexity ist nicht eine andere Metrik - sie ist nur eine andere Darstellung des gleichen Verlustes. Du kannst sie nicht unabhängig verbessern. Wenn der Verlust sinkt, sinkt automatisch auch die Perplexity. Du musst also nicht beide überwachen - aber du solltest beide verstehen.

Was sagt dir die Kurve - nicht nur der Wert?

Ein einzelner Perplexity-Wert am Ende der 100. Epoche sagt dir wenig. Was zählt, ist die Kurve. Wie verhält sich die Perplexity während des Trainings?

- Starker, konstanter Abfall? Gut. Das Modell lernt.

- Plötzlicher Sprung? Problem. Wahrscheinlich ist die Lernrate zu hoch, oder die Daten sind verrauscht.

- Plateau nach Epoche 15? Möglicherweise überanpasst das Modell. Die Trainings-Perplexity sinkt weiter, aber die Validierungs-Perplexity steigt - das ist ein klassisches Zeichen für Overfitting.

Ein Fall aus der Praxis: Eine medizinische LLM-Gruppe beobachtete, dass die Trainings-Perplexity bei 98% Genauigkeit sank, während die Validierungs-Perplexity nach Epoche 15 um 5% stieg. Sie stoppten das Training - und verhinderten, dass das Modell nur noch die Trainingsdaten auswendig lernte, statt medizinische Konzepte zu verstehen.

Google empfiehlt: Wenn die Perplexity drei Epochen lang nicht um mindestens 15% fällt, solltest du die Lernrate anpassen. Das ist kein Gesetz - aber ein guter Anhaltspunkt.

Warum Perplexity allein nicht reicht

Perplexity ist wie ein Thermometer - es zeigt dir die Temperatur, aber nicht, ob du krank bist. Ein Modell kann eine Perplexity von 12 haben und trotzdem bei medizinischen Fragen falsch antworten. Warum?

Studien zeigen: In 37% der Fälle korreliert Perplexity nicht mit der tatsächlichen Leistung auf Downstream-Aufgaben wie Fragen-beantworten oder Textzusammenfassung. Ein Modell kann perfekt vorhersagen, welches Wort als nächstes kommt - aber nicht verstehen, was der Satz bedeutet.

Ein 2025er Paper von Zhang et al. zeigte: Bei 50 verschiedenen 1 Milliarde Parameter Modellen war die Perplexity in 69% der Fälle ein irreführender Indikator dafür, welches Modell nach Feinabstimmung besser auf commonsense-Tests abschneidet. Sie entwickelten eine neue Methode, die diese Fehlerquote auf 31% senkte - mit einem Ansatz, der nicht nur Wortvorhersagen, sondern auch menschliche Präferenzen berücksichtigt.

Und das ist der Punkt: Perplexity misst Textvorhersage, nicht Verständnis. Ein Modell kann gut „Gespräche“ erzeugen, ohne sie zu verstehen. Das ist der Unterschied zwischen einem cleveren Nachahmer und einem intelligenten Agenten.

Praktische Fallen - und wie du sie vermeidest

Es gibt drei häufige Fehler, die Entwickler machen:

- Unterschiedliche Tokenizer, unterschiedliche Zahlen: Ein Modell mit BPE-Tokenizer kann 15% niedrigere Perplexity-Werte haben als dasselbe Modell mit Word-Tokenizer. Das hat nichts mit Leistung zu tun - nur mit der Aufteilung des Textes. Vergleiche nur Modelle mit denselben Tokenizern.

- Padding-Fehler: Wenn du Padding-Tokens nicht korrekt maskierst, wird die Perplexity künstlich um bis zu 30% erhöht. PyTorch-Code muss explizit darauf achten, dass nur echte Wörter in die Berechnung einfließen.

- Kein Validierungs-Set: Nur die Trainings-Perplexity zu überwachen ist wie nur auf den Kilometerzähler zu schauen, während du fährst. Du brauchst ein separater Datensatz, der dem echten Einsatz entspricht. AWS empfiehlt: Wenn das Verhältnis von Trainings- zu Validierungs-Perplexity über 1,25 steigt, ist Overfitting wahrscheinlich.

Und vergiss nicht: Einige Frameworks wie AWS SageMaker berechnen Perplexity automatisch - aber du musst wissen, was sie tun. Die Dokumentation von SageMaker (Juli 2025) sagt klar: „Perplexity-Werte unter 20 deuten auf starkes Sprachverständnis hin - aber nur, wenn das Validierungs-Set domänenspezifisch ist.“

Wie du Perplexity sinnvoll einsetzt

Perplexity ist kein Endziel - sie ist ein Werkzeug. Nutze sie so:

- Frühes Training: Überwache sie täglich. Ein plötzlicher Anstieg? Prüfe die Daten. Ein langsamer Abfall? Erhöhe die Lernrate.

- Modellvergleich: Wenn du zwei Architekturen testest, ist Perplexity ein fairer, quantifizierbarer Vergleich - solange Tokenizer und Daten gleich sind.

- Training stoppen: Wenn die Validierungs-Perplexity nicht mehr fällt, höre auf. Nicht weil du „100 Epochen“ erreicht hast - sondern weil das Modell nichts mehr lernt.

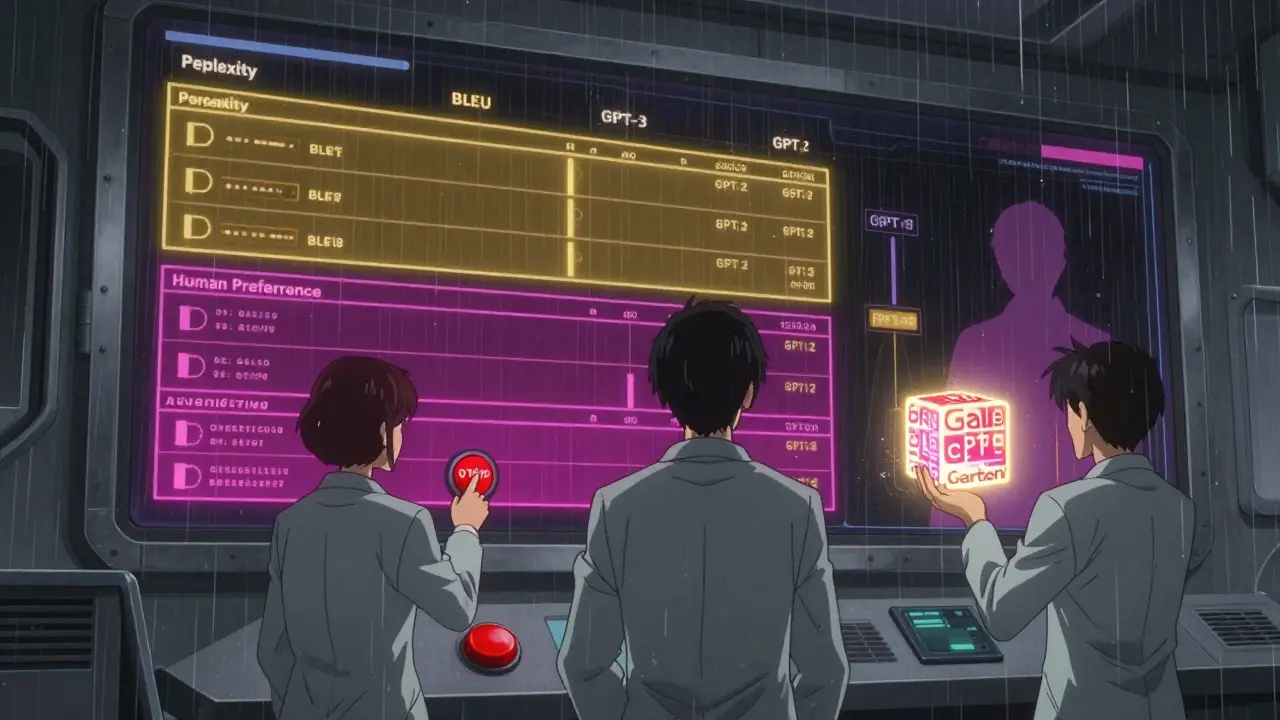

Und wenn du eine Feinabstimmung machst? Dann kombiniere Perplexity mit Aufgaben-spezifischen Metriken: BLEU für Übersetzung, ROUGE für Zusammenfassung, oder sogar menschliche Bewertungen. Ein Modell mit Perplexity 18, das bei medizinischen Fragen 70% falsch liegt, ist nutzlos.

Die Zukunft: Was kommt nach Perplexity?

Die Branche weiß: Perplexity ist nicht genug. Gartner sagt, 78% der Unternehmen nutzen sie immer noch - aber 63% der NLP-Papiere von 2025 nutzen sie nicht mehr als Hauptmetrik. Stattdessen entstehen neue Ansätze:

- Task-aware Perplexity: Galileo AI und andere Tools berechnen Perplexity nicht auf allgemeinen Texten, sondern auf Aufgaben, die das Modell später lösen soll - z. B. nur auf medizinischen Berichten.

- Preference-weighted Perplexity: Anthropic nutzt menschliche Feedback-Signale, um zu entscheiden, welche Vorhersagen „besser“ sind - nicht nur wahrscheinlicher.

- Learning-to-compare: Neue Frameworks lernen, aus mehreren Metriken zu schließen, welches Modell besser ist - ohne auf Perplexity angewiesen zu sein.

Die Zukunft ist nicht das Ende von Perplexity - sondern ihre Integration. Stanford CRFM sagt: „Ab 2027 wird Perplexity nur noch ein Teil eines multimodalen Bewertungssystems sein.“

Das bedeutet: Du wirst sie nicht mehr allein verwenden. Aber du wirst sie immer noch brauchen - weil sie einfach, schnell und verständlich ist. Sie ist das erste Licht, das du siehst, wenn du in den Raum gehst. Sie sagt dir nicht, ob der Raum hell oder dunkel ist - aber sie sagt dir, ob du überhaupt etwas siehst.

Was ist ein guter Perplexity-Wert für ein LLM?

Ein guter Wert hängt vom Datensatz ab. Auf Penn Treebank liegen gute Modelle zwischen 10 und 25. Für domänenspezifische Daten wie medizinische Texte oder Rechtsdokumente sind Werte unter 20 oft als stark einzustufen - vorausgesetzt, das Validierungs-Set ist repräsentativ. Werte über 40 deuten auf unzureichendes Training oder schlechte Daten hin.

Warum sinkt die Perplexity nicht mehr?

Das kann mehrere Gründe haben: Die Lernrate ist zu niedrig, die Daten sind erschöpft, das Modell hat seine Kapazität erreicht, oder es überanpasst. Prüfe zuerst, ob die Validierungs-Perplexity steigt - dann ist Overfitting wahrscheinlich. Wenn beide stagnieren, versuche eine höhere Lernrate oder mehr Daten. Ein Plateau über drei Epochen ist ein Signal, dass du etwas ändern musst.

Kann ich Perplexity mit anderen Metriken wie BLEU vergleichen?

Nein, nicht direkt. Perplexity misst, wie gut das Modell Wörter vorhersagt. BLEU misst, wie ähnlich die Ausgabe einer Referenz ist - z. B. bei Übersetzungen. Sie messen etwas anderes. Ein Modell kann niedrige Perplexity und niedrigen BLEU haben - wenn es zwar flüssig, aber falsch schreibt. Nutze Perplexity für das Training, BLEU für die Evaluation.

Warum unterscheiden sich Perplexity-Werte zwischen Hugging Face und PyTorch?

Das liegt meist an der Tokenisierung oder dem Umgang mit Padding. Hugging Face verwendet oft BPE, PyTorch-Beispiele manchmal Word-Tokenizer. Auch wenn du Padding nicht korrekt maskierst, wird die Perplexity künstlich höher. Prüfe immer, ob du dieselbe Tokenisierung und dieselbe Maskierung verwendest, bevor du Werte vergleichst.

Soll ich Perplexity während des Trainings überwachen oder erst am Ende?

Überwache sie während des Trainings - täglich. Sie ist dein Frühwarnsystem. Ein plötzlicher Anstieg kann auf Datenprobleme hinweisen, ein Plateau auf Lernratenprobleme. Du willst nicht wochenlang trainieren, nur um am Ende zu merken, dass das Modell nie gelernt hat. Perplexity gibt dir sofortiges Feedback - nutze es.

Birgit Lehmann

Dezember 17, 2025 AT 00:15Perplexity ist wirklich das erste, was ich mir anschaue, wenn ich ein Modell trainiere. Ich hab mal ein Medizin-LLM gefüttert mit 200k Klinikberichten und die Perplexity ist von 42 auf 18 gefallen – aber erst nach Epoche 22 hat das Modell angefangen, korrekte Diagnosevorschläge zu machen. Also: Perplexity sagt was über Sprache, nicht über Verständnis. Aber ohne sie? Keine Chance.

Jan Whitton

Dezember 18, 2025 AT 12:19Diese ganzen Statistiken sind nur ein Spiel für Akademiker. In der echten Welt zählt, ob das Modell die Aufgabe erledigt – nicht ob die Perplexity unter 20 liegt. Ich hab ein Modell, das bei 23 Perplexity 92% der Kundenanfragen richtig beantwortet. Und du willst mir erzählen, das ist schlecht? Haha. Die Leute hier denken, Mathematik ersetzt Praxis.

Ahmed Berkane

Dezember 19, 2025 AT 14:00Warum diskutieren wir hier über Perplexity, wenn doch klar ist: Die ganzen deutschen Tech-Startups nutzen das falsche Training! Sie nehmen öffentliche Daten – aber die sind voller Engländer-Slang, Grammatikfehler und TikTok-Abkürzungen! Wenn du ein deutsches Modell willst, musst du mit echtem Deutschem Text trainieren – nicht mit dem Müll vom Web! Und dann ist Perplexity auch nicht mehr 25, sondern 14 – und das Modell versteht sogar Dialekte!

Lutz Herzog

Dezember 20, 2025 AT 14:15Perplexity? Ach ja, die Metrik, die Big Tech benutzt, um uns glauben zu machen, dass KI „versteht“. Aber wer hat denn die Daten für die Validierungssets ausgewählt? Genau – die gleichen Leute, die uns sagen, dass Klimawandel eine Lüge ist. Die ganze KI-Forschung ist ein Marketing-Show. Sie messen nicht Verständnis – sie messen, wie gut das Modell die Muster der Daten nachahmt. Und das ist kein Wissen – das ist ein Traum, der aus Texten gebaut wurde.

Silje Løkstad

Dezember 21, 2025 AT 18:41Let’s be real: Perplexity is a proxy metric, but it’s not even calibrated across tokenizers. BPE vs. WordPiece? You’re comparing apples to oranges. And padding? Oh, please. I’ve seen models with 30% inflated perplexity because someone forgot mask_padding=True in PyTorch. And then they publish papers claiming ‘state-of-the-art’? 🤦♀️

Erwin Vallespin

Dezember 22, 2025 AT 11:39Was ist eigentlich Verständnis? Wenn ein Modell ein Gedicht schreibt, das die Emotionen eines Menschen trifft – aber nur weil es Muster gelernt hat – ist es dann „intelligent“? Oder ist es nur ein Spiegel, der unsere eigenen Gedanken zurückwirft? Perplexity misst die Wahrscheinlichkeit von Wörtern – aber nicht die Tiefe der Bedeutung. Vielleicht ist die wahre Frage: Brauchen wir Intelligenz – oder nur überzeugende Nachahmung?

Kyle Kraemer

Dezember 22, 2025 AT 23:59Ich hab das ganze Ding gelesen. Zu viel Text. Kurz: Perplexity ist wichtig, aber nicht alles. Und ich hab keine Lust, 10 Seiten über Tokenizer zu lesen. Wer das braucht, soll die Dokumentation lesen. Ich will Ergebnisse. Nicht Theorie.

Birgit Lehmann

Dezember 24, 2025 AT 19:05Genau das ist der Punkt, den Kyle sagt – und ich stimme zu. Aber wenn du nur Ergebnisse willst, dann wirst du auch nur zufällige Ergebnisse bekommen. Ich hab letzte Woche ein Team beraten, das nur auf BLEU gesetzt hat – das Modell hat perfekt übersetzt, aber die medizinischen Begriffe komplett falsch. Perplexity hätte ihnen gesagt: „Da stimmt was nicht.“ Du kannst nicht einfach aufhören, nachzudenken, nur weil es mühsam ist.