Speicher- und Rechenlast von Transformer-Schichten in produktiven großen Sprachmodellen

Stellen Sie sich vor, Sie haben ein großes Sprachmodell wie Llama 3.1 70B auf einem Server laufen. Es antwortet auf Ihre Fragen, schreibt Texte, analysiert Dokumente - alles fast in Echtzeit. Doch hinter dieser scheinbaren Leichtigkeit verbirgt sich eine riesige Last: Speicher und Rechenleistung. Jede einzelne Transformer-Schicht in diesem Modell frisst Gigabyte an RAM und teraflops an Rechenkapazität. Und wenn Sie das nicht verstehen, scheitert Ihre Implementierung - nicht an der Technik, sondern an der Planung.

Was genau frisst den Speicher in einem Transformer?

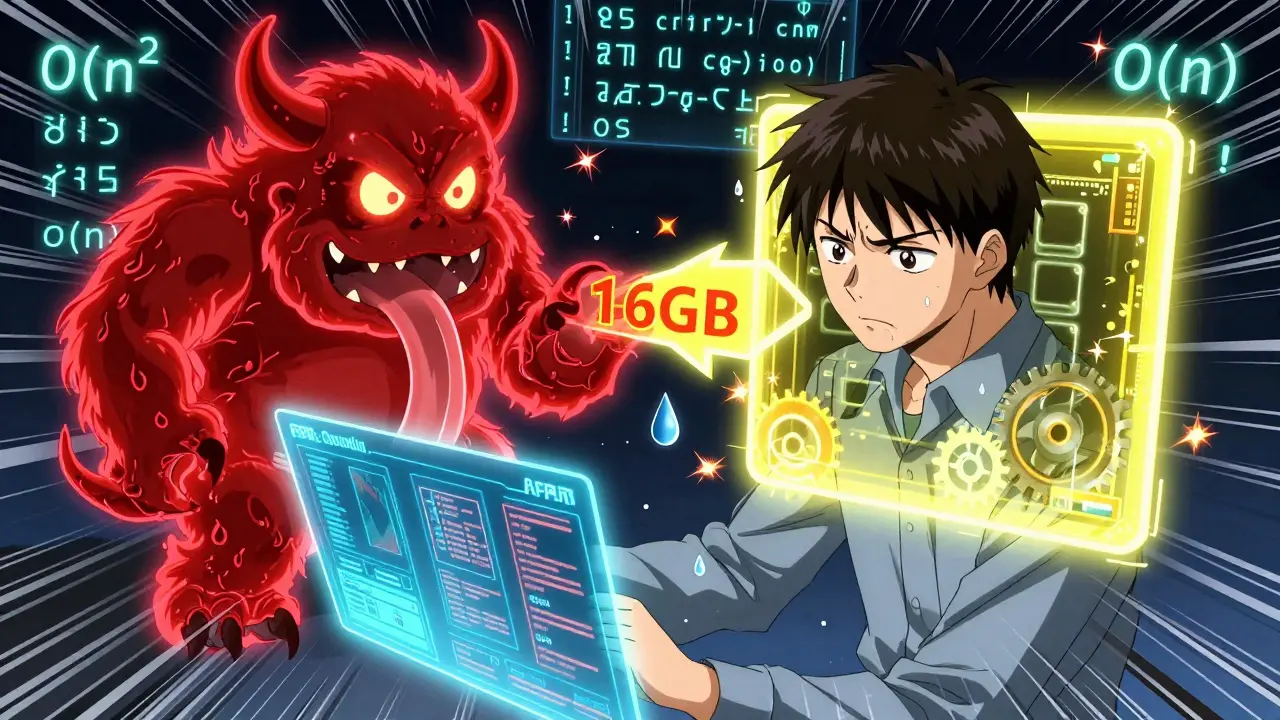

In einem großen Sprachmodell gibt es zwei Hauptverbraucher von Speicher: die Modellgewichte und der Key-Value (KV)-Cache. Die Gewichte sind die gelernten Parameter des Modells - die Zahlen, die sagen, wie sich Eingaben durch die Schichten bewegen. Ein 7 Milliarden Parameter starkes Modell wie Llama 2 7B in 16-Bit-Precision (FP16) benötigt etwa 14 GB Speicher. Das klingt viel, ist aber nur die halbe Wahrheit. Der echte Überraschungskandidat ist der KV-Cache. Er speichert die Schlüssel- und Wert-Vektoren, die bei jeder vorherigen Token-Berechnung entstanden sind. Bei einer Sequenzlänge von 4.096 Tokens und einem 7B-Modell mit 32 Schichten, 8 KV-Köpfen und einem Kopf-Dimension von 128 verbraucht dieser Cache allein etwa 2 GB. Klingt überschaubar? Doch bei 32.000 Tokens - typisch für lange Dokumente oder Chatverläufe - steigt dieser Wert auf über 16 GB. Bei einem 70B-Modell wird der KV-Cache sogar größer als die Gewichte selbst. Das ist kein theoretisches Problem. In der Praxis sehen Unternehmen, dass sie nicht genug GPU-Speicher haben, weil der Cache die gesamte Bandbreite verschlingt.Rechenlast: Warum Ihre GPU nur 30 % auslastet

Die Rechenlast folgt einer einfachen, aber brutalen Regel: O(dn²/c). Dabei steht n für die Sequenzlänge, d für die Embedding-Dimension und c für die Anzahl der parallelen Kerne. Das bedeutet: Wenn Sie die Länge des Textes verdoppeln, vervierfacht sich der Rechenaufwand. Bei 128.000 Tokens - wie sie heute in manchen Anwendungen verwendet werden - ist die Rechenlast astronomisch hoch. Aber hier liegt der Haken: GPUs sind dafür ausgelegt, viele Berechnungen gleichzeitig durchzuführen. Bei kleinen Batch-Größen - wie sie typisch für interaktive Chatbots sind - bleibt die GPU fast die ganze Zeit untätig. Sie wartet auf Daten aus dem Speicher, während die Recheneinheiten leer stehen. NVIDIA hat gemessen, dass bei Transformer-Attention-Schichten nur 30 bis 35 % der theoretischen Rechenleistung genutzt werden. Der Rest ist Wartezeit. Das ist kein Fehler Ihrer Hardware - das ist die Architektur der Transformer.Memory-bound vs. compute-bound: Die entscheidende Frage

Jede erfolgreiche Optimierung beginnt mit einer einfachen Frage: Ist mein System speicherbegrenzt oder rechenbegrenzt? Das ist kein akademischer Unterschied - es bestimmt, wohin Sie Ihre Ressourcen stecken. Wenn Sie lange Kontexte verarbeiten - etwa 16.000+ Tokens - ist Ihr System fast immer speicherbegrenzt. Der KV-Cache wächst linear mit der Sequenzlänge und der Batch-Größe. Hier bringt es nichts, mehr Rechenleistung zu kaufen. Sie brauchen einen kleineren Cache. Techniken wie FlashAttention-2 reduzieren den Speicherbedarf von quadratisch auf linear, indem sie die Berechnungen in kleine Blöcke aufteilen. So können Sie mit einem 80 GB A100 128.000 Tokens verarbeiten - ohne FlashAttention wäre das unmöglich. Aber wenn Sie kurze Prompts mit komplexen Antworten verarbeiten - etwa Code-Generierung oder logisches Denken - dann ist Ihr System rechenbegrenzt. Die Zeit wird nicht durch den Speicher verbraucht, sondern durch die Berechnung der Attention-Matrix. Hier hilft kein KV-Cache-Compression. Hier brauchen Sie schnellere Berechnungen. Snowflake hat gezeigt: Eine 50 %ige Reduktion der Prefill-Rechenlast bringt eine 52 %ige Steigerung der Durchsatzrate - bei einem 70B-Modell. Das ist kein kleiner Gewinn. Das ist der Unterschied zwischen einem nutzbaren System und einem, das ständig wartet.

Optimierungstechniken: Was wirklich funktioniert

Es gibt viele Versprechen - aber nur wenige Techniken, die in der Praxis standhalten.- INT8-Quantisierung: Reduziert den Speicherbedarf der Gewichte um die Hälfte. Ein 70B-Modell fällt von 140 GB auf 70 GB. Aber Vorsicht: Bei INT4 sinkt die Genauigkeit auf dem MMLU-Benchmark um 8,7 %. Für rechtliche oder medizinische Anwendungen ist das oft unzulässig.

- Tensor-Parallelismus: Teilt die Attention-Köpfe auf mehrere GPUs auf. Perfekt für rechenbegrenzte Workloads. Aber es bringt 15-25 % Overhead durch Kommunikation - wenn Sie es falsch konfigurieren, verlieren Sie mehr, als Sie gewinnen.

- Pipeline-Parallelismus: Teilt die Schichten auf. Gut für speicherbegrenzte Systeme. Aber bei 70B-Modellen kann der Overhead bis zu 22 % betragen - wie ein Nutzer auf Reddit berichtet, der 45 Minuten brauchte, um den KV-Cache auf 8 A100s unterzubringen.

- FlashAttention-2 und -3: Die einzige Technik, die die Speicheranforderungen der Attention von O(n²) auf O(n) senkt. FlashAttention-3 (September 2024) bringt weitere 28 % Einsparungen durch Kernel-Fusion. Wenn Sie längere Kontexte brauchen, ist das Ihr Schlüssel.

- SwiftKV: Eine neue Methode, die die Prefill-Rechenlast halbiert, indem sie KV-Vektoren zwischen verschiedenen Eingaben wiederverwendet. 50 % weniger Rechenzeit - das ist ein Game-Changer für Code-Generierung und Analyse.

Was schiefgeht - und warum

Die meisten Projekte scheitern nicht an der Technik. Sie scheitern an falschen Annahmen. Ein Team optimiert den KV-Cache, weil sie glauben, Speicher sei das Problem. Doch ihre Anwendung verarbeitet nur 512-Tokens-Prompts - und braucht 3 Sekunden, um eine Antwort zu generieren. Der echte Engpass ist die Prefill-Rechenlast. Sie haben 10.000 Dollar in Cache-Kompression investiert - und nichts gewonnen. Ein anderes Unternehmen setzt INT4-Quantisierung ein, um Kosten zu senken. Doch ihr Modell verarbeitet juristische Dokumente. Die Genauigkeit sinkt um 6 %. Die Kunden reklamieren. Die Compliance-Abteilung stoppt den Einsatz. Die häufigsten Fehler:- Unterschätzen, wie schnell der KV-Cache wächst - besonders bei großen Modellen und hohen Batch-Größen.

- Ignorieren, dass die Rechenlast bei kurzen Prompts nicht vom Speicher, sondern von der Attention-Berechnung dominiert wird.

- Verwenden von Optimierungen ohne Profiling. Sie wissen nicht, wo der Engpass ist - also optimieren Sie zufällig.

- Übersehen, dass einige Techniken (wie KV-Cache-Compression) kleine Genauigkeitsverluste verursachen - die in sensiblen Anwendungen untragbar sind.

Wie Sie anfangen - Schritt für Schritt

Sie brauchen kein PhD, um das zu meistern. Aber Sie brauchen eine klare Strategie.- Profiling: Nutzen Sie NVIDIA Nsight Systems. Messen Sie, wie viel Zeit die GPU mit Warten verbringt - und wie viel mit Rechnen. Wenn das Verhältnis 1:3 ist, sind Sie rechenbegrenzt. Wenn das Speicherlimit erreicht ist, bevor Sie rechnen können, sind Sie speicherbegrenzt.

- Wählen Sie die richtige Optimierung: Bei langen Kontexten → FlashAttention + INT8. Bei kurzen, komplexen Prompts → SwiftKV + Tensorparallelismus.

- Testen Sie mit echten Daten: Nutzen Sie Ihre eigenen Prompts. Nicht die Beispieltexte aus der Dokumentation. Ein Modell, das bei „Was ist die Hauptstadt von Frankreich?“ gut funktioniert, kann bei einem 10.000-Wörter-Vertrag versagen.

- Überwachen Sie die Genauigkeit: Führen Sie regelmäßig Benchmarks auf MMLU, HumanEval oder Ihrem spezifischen Datensatz durch. Ein 5 %iger Genauigkeitsverlust klingt klein - aber in der Praxis ist das ein verlorener Kunde.

Was kommt als Nächstes?

Die Hardware entwickelt sich. NVIDIA hat mit dem Blackwell B200 eine GPU mit 192 GB HBM3e-Speicher vorgestellt - speziell für KV-Cache-Lasten. Samsung arbeitet an Hybrid-Speichern mit GDDR7. Und Meta plant Llama 4 mit speziell optimierten Attention-Mustern für diese Chips. Aber die größte Veränderung kommt nicht von der Hardware. Sie kommt von der Architektur. Die Forschung zeigt: Die Zukunft liegt in Modellen, die nicht mit quadratischer Komplexität arbeiten. In Modellen, die den KV-Cache nicht speichern, sondern neu berechnen - oder ganz eliminieren. Bis dahin: Verstehen Sie Ihren Engpass. Messen Sie, bevor Sie optimieren. Und vergessen Sie nicht: Die größte Gefahr ist nicht, zu wenig Speicher zu haben. Sondern zu viel Zeit in die falsche Optimierung zu stecken.Warum ist der KV-Cache bei großen LLMs so problematisch?

Der KV-Cache speichert alle vorherigen Schlüssel- und Wert-Vektoren, die bei der Verarbeitung eines Textes entstehen. Bei langen Sequenzen (z. B. 32.000 Tokens) kann er mehr Speicher verbrauchen als die Modellgewichte selbst - besonders bei Modellen mit über 70 Milliarden Parametern. Da er linear mit der Sequenzlänge und der Batch-Größe wächst, wird er zum Hauptengpass bei Chatbots, Dokumentenanalysen oder langen Konversationen.

Ist INT4-Quantisierung sicher für Produktions-LLMs?

Nein - nicht für alle Anwendungen. INT4 reduziert den Speicherbedarf um 75 %, aber bei Modellen wie Llama 3.1 70B sinkt die Genauigkeit auf dem MMLU-Benchmark um bis zu 8,7 %. Das ist akzeptabel für Chatbots mit informellen Fragen, aber nicht für juristische, medizinische oder finanzielle Anwendungen, wo Präzision kritisch ist. Testen Sie immer mit Ihren eigenen Daten.

Welche Technik reduziert die Rechenlast am effektivsten?

SwiftKV ist derzeit die effektivste Methode zur Reduzierung der Prefill-Rechenlast. Es reduziert die Berechnung von Attention-Matrizen um bis zu 50 %, indem es KV-Vektoren zwischen ähnlichen Eingaben wiederverwendet. Bei einem 70B-Modell bringt das eine 52 %ige Steigerung der Durchsatzrate - mehr als jede andere Technik, die nicht Hardware-basiert ist.

Kann ich FlashAttention überall verwenden?

FlashAttention-2 und -3 funktionieren nur mit bestimmten GPU-Architekturen (Ampere, Hopper, Blackwell) und unterstützen nur bestimmte Sequenzlängen und Batch-Größen. Sie erfordern auch spezifische Frameworks wie vLLM oder TensorRT-LLM. Nicht jede LLM-Plattform unterstützt sie - prüfen Sie die Dokumentation, bevor Sie sie einsetzen.

Was ist der Unterschied zwischen Tensor- und Pipeline-Parallelismus?

Tensor-Parallelismus teilt die Attention-Köpfe und Gewichte auf mehrere GPUs auf - ideal für rechenintensive Workloads. Pipeline-Parallelismus teilt die Schichten auf - ideal, wenn der Speicher begrenzt ist. Tensor-Parallelismus hat geringeren Overhead bei hohen Rechenlasten, Pipeline-Parallelismus ist besser, wenn Sie den Speicher knapp haben. Mischen Sie beide nicht ohne Profiling - der Overhead kann bis zu 25 % betragen.

Warum nutzen Unternehmen nicht mehr Compute-in-Memory (CIM)?

CIM-Architekturen (wie IBM TrueNorth oder Samsungs Prototyp) sind theoretisch 3,7-mal energieeffizienter und 5,2-mal schneller. Aber sie unterstützen keine dynamischen Sparsamkeitsmuster, die Transformer-Attention erfordert. Sie sind für feste Muster wie CNNs geeignet, nicht für variable Attention-Matrizen. Bislang sind sie nur Forschungsprototypen - keine Produktionslösung.

Wie viel Speicher brauche ich für Llama 3.1 8B mit 16K Kontext?

Mit FP16-Precision: Ca. 18-20 GB. Davon sind etwa 12 GB für die Gewichte und 6-8 GB für den KV-Cache. Mit FlashAttention-2 können Sie den Cache-Speicher auf 2-3 GB reduzieren - dann reicht ein einzelner 24 GB A10. Ohne FlashAttention brauchen Sie mindestens zwei GPUs.

Sind Open-Source-Frameworks wie vLLM zuverlässig für Unternehmen?

Ja - vLLM ist in der Praxis die zuverlässigste Open-Source-Lösung. Es hat eine 4,7/5-Bewertung auf Hugging Face, unterstützt FlashAttention, SwiftKV und INT8/INT4, und wird von Unternehmen wie NVIDIA und Intel genutzt. Es hat über 1.200 Issues und 387 Pull Requests im Q3 2024 - das bedeutet, dass Probleme schnell behoben werden. Es ist die Standardwahl für viele Startups und Fortune-500-Unternehmen.

Karoline Abrego

Dezember 17, 2025 AT 13:07FlashAttention-2 ist geil, aber bei mir läuft’s trotzdem nur mit 12% Auslastung. Irgendwas stimmt nicht.

Alexandra Schneider

Dezember 17, 2025 AT 15:57ich hab das mit dem kv-cache auch erst kapiert, als mein server einfach abgestürzt ist 😅 man denkt, 80gb gpu reichen, aber nein. der cache frisst alles. jetzt nutz ich flashattention und es fühlt sich an, als hätte ich ne neue gpu.

sylvia Schilling

Dezember 19, 2025 AT 10:07Die Leute, die INT4 in medizinischen Anwendungen einsetzen, sollten sich schämen. Es ist nicht nur unprofessionell – es ist gefährlich. Wir reden hier nicht über Chatbots, die ‘wie geht’s?’ beantworten, sondern über Leben und Tod. Wer das ignoriert, hat kein Recht, von ‘Optimierung’ zu sprechen.

Anton Deckman

Dezember 21, 2025 AT 02:50Ich find’s faszinierend, wie so ein Modell wie ein lebendiger Organismus funktioniert – mit seinem Speicherbedarf, seiner Energieverschwendung, seiner Trägheit. Es ist nicht nur Technik, es ist Philosophie. Wir bauen uns KI-Geister, die uns mehr Ressourcen abverlangen als wir uns selbst geben. Und dann wundern wir uns, warum alles so langsam ist. Vielleicht ist die Lösung nicht mehr Rechenleistung, sondern weniger Ego. Weniger Prompts. Weniger Daten. Einfach… ruhiger.

Sabine Kettschau

Dezember 22, 2025 AT 02:26Wieder so ein Typ, der mit 1000-Buchstaben-Texten herumspielt, während echte Entwickler in der Realität mit 16GB-GPUs kämpfen. FlashAttention? SwiftKV? Wer hat denn Zeit, das alles zu konfigurieren? Ich hab ein Produkt, das laufen muss – nicht ein Forschungsprojekt. Wenn du nicht mit Standardtools arbeiten kannst, bist du nicht bereit für Production. Und nein, vLLM ist nicht ‘zuverlässig’ – es ist ein Haufen Code von Leuten, die noch nie einen Live-Server gesehen haben.

Michelle Fritz

Dezember 23, 2025 AT 17:54INT8 ist für Amateure, FlashAttention für Nerds, und SwiftKV für die, die glauben, sie könnten Mathematik durch Zaubertricks ersetzen. Wer wirklich was erreichen will, nutzt Llama 3.1 mit 4x H100 und hält den Mund. Keine Optimierungen. Keine Kompromisse. Nur Macht. Und wer das nicht versteht, hat nichts verstanden.

Max Weekley

Dezember 25, 2025 AT 04:13hab grad meinen ersten 70b-modell-server am laufen mit flashattention-3 und 24gb a10 – läuft wie butter. keine ahnung warum alle so kompliziert denken. einfach die richtigen tools nutzen und los. ich hab sogar noch ram übrig für memes 😎

Elien De Sutter

Dezember 25, 2025 AT 10:28Ich find’s so schön, wie ihr alle so leidenschaftlich über Speicher und Attention-Köpfe diskutiert… es ist, als würdet ihr ein Gedicht schreiben, das nur diejenigen verstehen, die schon mal eine GPU zum Weinen gebracht haben. 🌈 Ich hab nur eine kleine GPU, aber ich liebe sie trotzdem. Und ich glaube, es geht nicht darum, alles zu optimieren – sondern darum, mit dem zu arbeiten, was man hat. Vielleicht ist die wahre Innovation nicht die Technik… sondern die Geduld.

Stefan Sobeck

Dezember 26, 2025 AT 02:51hab grad den comment von anton gelesen… und ja. wir bauen geister. und die wollen gefüttert werden. aber ich frag mich: wer hat uns eigentlich gesagt, dass wir so viel text brauchen? vielleicht ist die antwort nicht mehr rechenleistung… sondern weniger fragen. einfach mal still sein. und gucken.