RAG-Pipelines testen und überwachen: Synthetische Abfragen und echter Verkehr

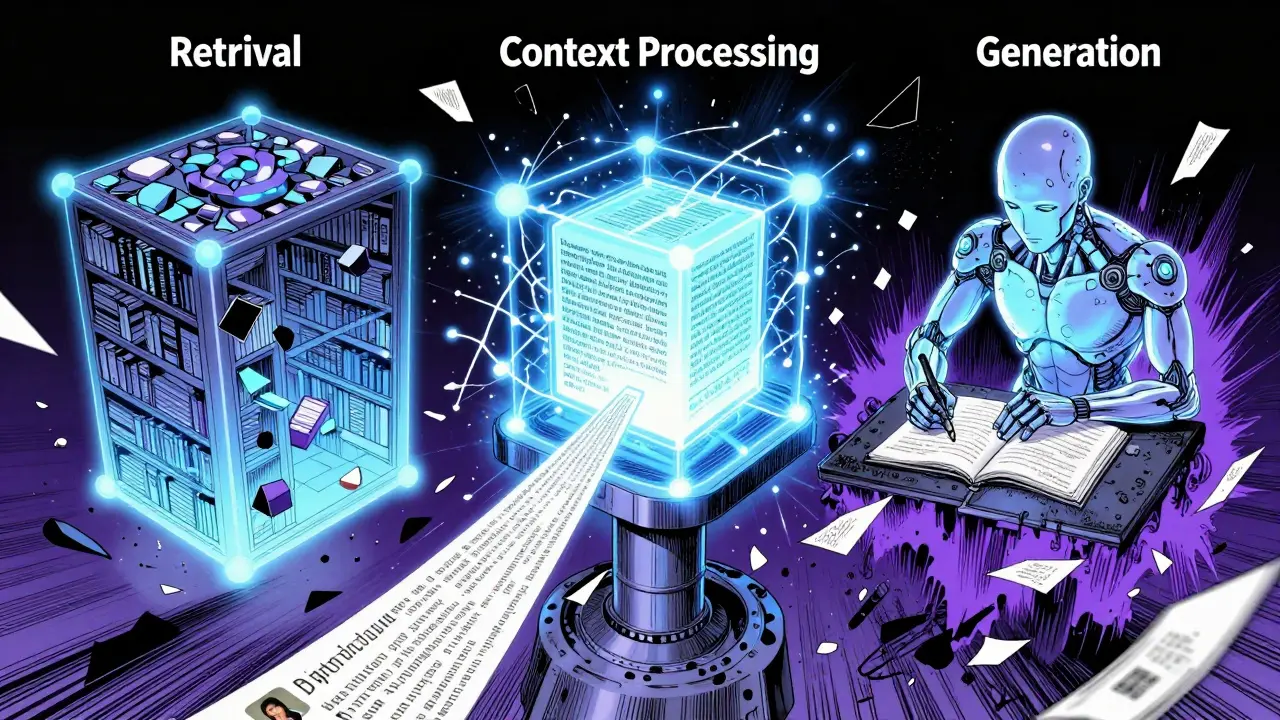

Wenn du eine RAG-Pipeline in Produktion hast, dann weißt du: Sie funktioniert nicht einfach nur. Sie besteht aus mehreren Schritten - Retrieval, Kontext-Aufbereitung, Generierung - und jeder Schritt kann scheitern. Ein paar synthetische Tests laufen, und alles scheint perfekt. Doch in der echten Welt, bei echten Nutzern, kommt plötzlich eine Anfrage, die alles zum Einsturz bringt. Warum? Weil synthetische Tests nicht alles abdecken. Und Echtzeit-Monitoring? Meistens fehlt es an den richtigen Werkzeugen.

Was ist eine RAG-Pipeline wirklich?

Eine RAG-Pipeline (Retrieval-Augmented Generation) holt zuerst relevante Dokumente aus einer Datenbank, dann nutzt sie diese als Kontext, um eine Antwort zu generieren. Klingt einfach. Aber das Problem liegt in der Schnittstelle. 63 % aller Ausfälle passieren genau dort, wo das Retrieval auf die Generierung trifft. Ein Dokument wird richtig gefunden, aber der LLM ignoriert es. Oder er verfälscht es. Oder er braucht 4,7 Sekunden, weil der Kontext zu lang ist. Das merkst du nicht, wenn du nur mit vordefinierten Fragen testest.

Die meisten Teams testen nur mit synthetischen Abfragen - also künstlich erstellten Fragen, die auf Benchmarks wie MS MARCO oder FiQA basieren. Das ist gut. Aber es ist nicht genug. Eine Studie von MIT aus Juli 2024 zeigt: Synthetische Abfragen unterschätzen komplexe, mehrteilige Nutzeranfragen um 45-60 %. Das bedeutet: Du testest eine einfache Frage wie „Was ist der Gewinn von Apple?“, aber der echte Nutzer fragt: „Wie hat sich der Gewinn von Apple in den letzten drei Quartalen verändert, wenn man die Steuern und die Wechselkurse berücksichtigt?“ - und das wird in deinen Tests nie abgebildet.

Synthetische Tests: Kontrolliert, aber unvollständig

Synthetische Tests sind wie ein Rechentest in der Schule. Du kennst die Fragen, du hast die richtigen Antworten, du kannst messen, ob die Lösung passt. Tools wie Ragas bieten dir dafür Metriken: Faithfulness (Wie sehr stimmt die Antwort mit dem Kontext überein?), Answer Relevancy (Ist die Antwort überhaupt relevant?), und Context Relevancy (Waren die abgerufenen Dokumente überhaupt nützlich?).

Ein guter Wert liegt zwischen 0,6 und 0,9 auf einer Skala von 0 bis 1. Aber hier ist der Haken: Diese Metriken korrelieren oft schlecht mit echter Nutzerzufriedenheit. Eine Studie von LangChain mit 12 Unternehmen ergab: Der Zusammenhang zwischen Context Relevancy und Nutzerfeedback war nur r=0,37 - fast kein Zusammenhang. Das heißt: Deine Pipeline kann eine hohe Score haben und trotzdem von Nutzern als nutzlos abgelehnt werden.

Und dann ist da noch der Aufwand. Laut Braintrust.dev verbraucht die Erstellung eines guten synthetischen Datensatzes 40-60 % der gesamten Entwicklungszeit. Du musst nicht nur Fragen schreiben, sondern auch die richtigen Kontexte dazu erstellen - und das für jede Domäne: Finanzen, Medizin, Recht. Ein Unternehmen in der Finanzbranche nutzt den FiQA-Datensatz mit 6.000 Fragen. Aber selbst das reicht nicht, wenn deine Nutzer plötzlich nach „Wie wirkt sich eine Zinserhöhung auf mein Darlehen aus, wenn ich 3 Kinder habe?“ fragen. Synthetische Tests sind ein Sicherheitsnetz - aber kein vollständiger Schutz.

Echter Verkehr: Die Wahrheit hinter den Zahlen

Echte Nutzeranfragen sind chaotisch. Sie sind unvollständig, sie enthalten Tippfehler, sie sind emotional, sie sind komplex. Und sie sind die einzige Quelle, die dir zeigt, was wirklich schief läuft. Ein Startup-CTO berichtete auf HackerNews, dass ein Echtzeit-Monitoring eine kritische Schwachstelle in der Finanzabfrage erkannte - 12 % der Anfragen lieferten völlig falsche Daten. Der Grund? Der synthetische Datensatz enthielt nur einfache Unternehmensgewinn-Fragen. Die komplexen, kontextabhängigen Anfragen? Gar nicht vorhanden.

Du kannst nicht einfach „wie gut“ messen. Du musst was schiefging, wann es geschah, und wie es sich auswirkte. Dafür brauchst du Distributed Tracing - also eine Spur, die jede Anfrage durch alle Komponenten verfolgt: Von der Eingabe über den Vector Store bis zur Antwort des LLM. Maxim AI und Langfuse bieten das mit weniger als 50 ms Overhead pro Anfrage. TruLens? Du musst 8-12 Komponenten manuell instrumentieren. Das ist aufwendig.

Und dann die Kosten. Ragas kann bis zu 15 $ pro 1.000 Anfragen kosten, wenn du jede einzelne trace-basiert auswertest. Die meisten Unternehmen nehmen nur 10 % der Anfragen als Stichprobe - das spart 90 % der Kosten. Aber du verpasst dabei die seltenen, aber katastrophalen Fehler. Ein Fall aus der Gesundheitsbranche: Alle synthetischen Tests waren grün. Doch in der Produktion hallucinierte die Pipeline in 3,7 % der Fälle falsche Medikamentendosen. Ein Fehler, der tödlich sein könnte. Und der wurde nur durch Echtzeit-Monitoring entdeckt.

Die richtige Mischung: Synthetisch + Echt

Die besten Teams kombinieren beides. Sie nutzen synthetische Tests, um grundlegende Funktionen zu prüfen - z. B. ob die Pipeline bei einfachen Fragen korrekt antwortet. Aber sie lassen den echten Verkehr sprechen. Jede Anfrage, die eine hohe Latenz hat, eine hohe Fehlerquote oder eine niedrige Nutzerzufriedenheit zeigt, wird automatisch in einen neuen synthetischen Test umgewandelt.

Maxim AI hat das in Dezember 2024 eingeführt: Ihr System generiert automatisch adversariale Testfälle aus echten Fehlern - innerhalb von 24 Stunden. Das ist ein geschlossener Kreislauf: Echtverkehr → Fehler → synthetischer Test → automatisierte Prüfung in CI/CD → Vermeidung des Fehlers beim nächsten Release. Unternehmen mit automatisierten Quality Gates verhindern 83 % der Regressionen vor der Produktion. Ohne sie? Nur 22 %.

Und es gibt noch einen wichtigen Punkt: Die Metriken. Du musst nicht nur Faithfulness messen. Du musst auch sehen, wie oft Nutzer ihre Anfrage nachbessern. Wie lange sie auf die Antwort warten. Ob sie den Chat verlassen, nachdem sie eine Antwort erhalten haben. Diese operativen Metriken - Session Duration, Query Refinement Rate - sind oft besser als alle LLM-Metriken, um echte Performance zu messen.

Tools und Kosten: Open Source vs. Enterprise

Willst du starten? Dann hast du zwei Wege: Open Source oder Enterprise-Tools.

- Ragas und TruLens sind kostenlos. Aber du brauchst 20-40 Stunden pro Monat an Ingenieurzeit für Wartung, Integration und Anpassung. Und du musst selbst die Infrastruktur aufbauen.

- Maxim AI, Vellum und Langfuse kosten 1.500-5.000 $ pro Monat. Aber sie liefern alles: Tracing, automatisierte Tests, Dashboards, Alerts, und Integration in CI/CD. Vellum hat sogar eine „One-Click Test Suite“ - das wurde in 78 % der positiven G2-Bewertungen gelobt.

Und dann ist da noch die Sicherheit. Patronus.ai hat 2024 68 % der getesteten RAG-Pipelines auf Prompt-Injection-Angriffe geprüft. 68 % waren anfällig. Das ist kein theoretisches Risiko. Ein Nutzer kann gezielt eine Frage stellen, die den Kontext überschreibt - und dein System gibt vertrauliche Daten preis. Das ist kein Bug. Das ist eine Sicherheitslücke. Und die findet man nur mit Echtzeit-Monitoring und speziellen Sicherheits-Metriken.

Was du jetzt tun musst

Wenn du eine RAG-Pipeline hast - egal ob klein oder groß - dann musst du jetzt handeln. Hier ist dein konkreter Plan:

- Starte mit synthetischen Tests: Nutze Ragas und teste mindestens 100 Abfragen mit Faithfulness, Answer Relevancy und Context Relevancy. Setze Schwellenwerte: z. B. Faithfulness > 0,75.

- Installiere Distributed Tracing: Nutze Langfuse oder Maxim AI. Erfasse mindestens 10 % des echten Verkehrs. Sammle Latenz, Fehler, Antwortlänge, Nutzerfeedback.

- Erstelle einen Feedback-Zyklus: Jede Anfrage mit niedrigem Nutzerfeedback oder hoher Latenz wird automatisch als neuer synthetischer Test gespeichert. Füge sie zu deinem Testset hinzu.

- Setze Alerts: Wenn die Antwortzeit über 3 Sekunden steigt, wenn die Faithfulness unter 0,6 fällt, wenn die Fehlerquote über 5 % liegt - dann muss ein Team alarmiert werden.

- Prüfe auf Sicherheit: Füge Prompt-Injection-Tests zu deinem synthetischen Set hinzu. Nutze Tools wie Patronus.ai oder integrierte Sicherheits-Metriken in deinem Monitoring-Tool.

Die Zukunft von RAG liegt nicht in perfekten Tests. Sie liegt in kontinuierlichem Lernen. Die besten Systeme sind nicht die, die am besten synthetisch testen. Sie sind die, die aus jedem echten Fehler lernen - und ihn in einen besseren Test verwandeln.

Was kommt als Nächstes?

2025 wird das Jahr, in dem RAG-Monitoring zur Standardpraxis wird. Gartner prognostiziert: Bis 2026 werden 90 % der Unternehmen automatisierte Evaluation-Pipelines haben - heute sind es nur 35 %. AWS, Azure und Google Cloud bauen RAG-Überwachung direkt in ihre AI-Plattformen ein. Der Markt wächst von 120 Mio. $ im Jahr 2024 auf 480 Mio. $ bis 2026.

Die größte Herausforderung bleibt: Keiner einigt sich auf die gleichen Metriken. 79 % der Entwickler klagen über inkonsistente Definitionen. Das wird sich ändern. Aber bis dahin: Nutze, was funktioniert. Und lass dich nicht von Perfektion lähmen. Ein System, das 80 % der Fehler erkennt und automatisch korrigiert, ist besser als ein perfektes System, das nie in Produktion geht.

Runa Kalypso

Dezember 17, 2025 AT 07:57ich hab das mit den synthetischen tests auch erst gedacht, aber nachdem ich ne woche lang echte nutzeranfragen analysiert hab… wow. die fehler sind so viel krasser als gedacht. tippschreibfehler, halbe sätze, emotionale ausbrüche… das ist kein testfall, das ist mensch.

Catharina Doria

Dezember 17, 2025 AT 20:08Die Aussage, dass Ragas-Metriken mit Nutzerzufriedenheit kaum korrelieren (r=0,37), ist nicht nur korrekt, sie ist alarmierend. Die Industrie verlässt sich auf falsche Proxy-Metriken, weil sie bequem sind - aber in RAG ist die Latenz, die Query-Refinement-Rate und das Drop-off-Verhalten die einzigen echten KPIs. Wer nur Faithfulness misst, baut ein Schloss aus Sand. Und ja, 40-60% Entwicklungszeit für synthetische Datensätze? Ein krimineller Verschwendungssyndrom. Die Ressourcen gehören in Echtzeit-Logging, nicht in das Schreiben von künstlichen Fragen, die niemand je stellen würde.

Niklas Lindgren

Dezember 18, 2025 AT 04:34Leute, wir reden hier über KI, nicht über Excel-Tabellen. Wer glaubt, man kann mit 100 synthetischen Fragen eine echte RAG-Pipeline testen, der hat noch nie mit echten Nutzern zu tun gehabt. Die fragen doch nicht "Was ist der Gewinn von Apple?" - die fragen "Warum ist mein Konto leer, obwohl ich alles richtig gemacht hab?" und dann kriegt der Bot eine Antwort aus dem Jahr 2021 und der User schmeißt das ganze System weg. Echtzeit-Monitoring ist nicht optional. Das ist Überleben.

Ulrich Sander

Dezember 18, 2025 AT 06:01Ich hab das Gefühl, wir stehen am Anfang einer neuen Ära… 🌌 Die alten Methoden sind tot. Synthetische Tests? Ein Traum aus der Vergangenheit. Echter Verkehr? Das ist die Wahrheit, die uns zerreißt - und gleichzeitig heilt. Jede fehlerhafte Antwort, jedes lange Warten, jede verlassene Sitzung… das sind keine Bugs. Das sind Stimmen. Schreie aus dem digitalen Dunkel. Und wir müssen endlich zuhören. 🫂

Nick Ohlheiser

Dezember 18, 2025 AT 11:40Ich finde es so wichtig, dass du diesen Punkt ansprichst - wirklich, wirklich wichtig. 😊 Jeder, der sagt, "das ist doch nur eine KI, das kann doch nicht so schlimm sein", der versteht nicht, wie viel Vertrauen Menschen in diese Systeme setzen. Wenn jemand nach seiner Medikation fragt und die Antwort falsch ist… das ist kein technischer Fehler. Das ist eine Verletzung. Und deswegen brauchen wir nicht nur Tools - wir brauchen Verantwortung. Jede Anfrage zählt. Jeder Fehler zählt. Und jeder, der das ignoriert, trägt eine schwere Last.

Lieve Leysen

Dezember 19, 2025 AT 13:55Ich liebe diesen Ansatz mit dem Feedback-Zyklus!! 🤍 Endlich mal jemand, der nicht nur "mehr Daten" sagt, sondern "mehr Verständnis". Die Idee, echte Fehler automatisch in neue Tests zu verwandeln… das ist wie Lernen aus dem Leben. Nicht aus dem Lehrbuch. ❤️

Brecht Dekeyser

Dezember 20, 2025 AT 22:47Maxim AI ist der hammer… aber 5k monatlich? Ich will doch nur nicht, dass mein bot jemandem sagt, er soll 10x Paracetamol nehmen. Kann man das nicht auch mit open source hinkriegen? Ich hab 3 leute im team und einen kaffeeautomaten. 🤷♂️

Astrid Shapiro

Dezember 22, 2025 AT 03:01Die Aussage, dass 68 % der RAG-Pipelines anfällig für Prompt-Injection sind, ist nicht nur eine Statistik - sie ist ein Systemversagen. Wer diese Risiken ignoriert, handelt fahrlässig. Es geht nicht um "Sicherheit durch Beobachtung" - es geht um Sicherheit durch Design. Und wenn Sie glauben, dass ein einfacher Monitoring-Stack das löst, dann sind Sie entweder naiv oder verantwortungslos. Die Zeit für halbe Lösungen ist vorbei.

Julia Wooster

Dezember 22, 2025 AT 11:59Wie kann man nur so naiv sein? Open Source Tools wie Ragas sind für Amateure. Wer in Produktion ist, braucht Enterprise-Lösungen - oder er ist ein Risiko für sein Unternehmen, seine Nutzer und letztendlich für die gesamte Branche. Diese "günstigen" Lösungen kosten am Ende 10x mehr, weil sie nicht skalieren, nicht verlässlich sind und keine Compliance garantieren. Und dann kommt der Audit… und dann kommt der PR-Skandal. Und dann kommt die Kündigung. Wer spart, zerstört. Punkt.